“A pesar de no estar viva, puedo crear arte”, explica la robot en tono monocorde y moviendo apenas la cabeza, en la cámara alta del Parlamento del Reino Unido. La humanoide se llama Ai-Da y tiene peluca, ojos que pestañean, boca que se abre al ritmo de sus palabras, y un brazo biónico que pinta, dibuja y hace esculturas. Armada con cámaras en los globos oculares y algoritmos de inteligencia artificial (IA), Ai-Da también sabe escribir y recitar poesía. Fue la primera robot en retratar oficialmente a la reina Isabel II y parte de la primera exhibición de arte contemporáneo dentro de las pirámides de Giza. “La forma en que esto difiere de los humanos es la consciencia”, agrega ante el comité de legisladores que la convocó, flanqueada por el galerista Aidan Miller, uno de sus creadores junto con la empresa de robótica Engineered Arts e investigadores de la Universidad de Oxford.

El de Ai-Da es apenas un ejemplo de la creación de arte utilizando IA, es decir, sistemas computacionales que pueden hacer tareas que normalmente requieren inteligencia humana. Ya están disponibles al público distintas plataformas que pueden, con una mera instrucción, realizar pinturas, escribir textos de todo tipo, componer música e imitar voces con maestría admirable. El arte hecho con IA, además, ya encontró un mercado: el turco Refik Anadol vendió por 5,1 millones de dólares Alucinaciones de la máquina, una serie de videos realizados automáticamente con machine learning.

Es 11 de octubre de 2022 y la robot Ai-Da sigue exponiendo frente a los legisladores sobre el advenimiento de la IA. Hasta que una hace la pregunta cuya respuesta fueron a buscar: “¿Podría un robot reemplazar a los artistas completamente?”. Miller, cocreador de la máquina, se apura a comprobar que Ai-Da sigue funcionando con una prueba preestablecida. “Ai-Da”, le dice él. “Ai-Da”, responde ella. Segundos después, Ai-Da dirige su mirada a la legisladora y contesta.

borges.exe

En febrero de 2019 la fundación OpenAI creó GPT-2, un generador de texto. Si a este sistema de IA, basado en un algoritmo de deep learning (aprendizaje profundo), se le dan unas palabras, puede “predecir” cómo sigue la oración. OpenAI lo consideraba entonces “muy peligroso para lanzarlo al público”, pero le dieron acceso a una periodista de The Guardian. Ella escribió la primera línea de 1984, de George Orwell: “era un día frío y luminoso de abril y los relojes daban las trece”. La IA, reconociendo el tono y el género, siguió: “estaba en mi auto camino a un nuevo trabajo en Seattle. Le cargué nafta, puse la llave y lo dejé correr. Simplemente imaginé cómo sería el día. Cien años a partir de ahora. En 2045, era un maestro en una escuela en una parte pobre de la China rural. Comenzaba con historia china e historia de la ciencia”. Inmediatamente, la columnista Hannah Jane Parkinson escribió el ensayo “Una IA puede escribir igual que yo. Prepárense para el apocalipsis robot”, donde listaba sus miedos: fake news producidas masiva y automáticamente, la desaparición del mercado literario, entre otros escenarios.

OpenAI, creadora de la tecnología, es una fundación sin fines de lucro dedicada a la investigación y creación de IA. La inició en 2015 el multimillonario y mediático dueño de Twitter, Elon Musk, con una premisa simple: prevenir que surja una IA que domine a la humanidad creando otra que fuera amable, accesible y controlada. Su último gran inversor fue Microsoft, que puso 1000 millones de dólares en 2019.

Luego de GPT-2, en junio de 2020, vino GPT-3. El programa fue entrenado usando una base de datos exorbitante de libros digitalizados, páginas web y papers disponibles en Internet. En la actualidad, GPT-3 es lo más cercano a la promesa de una IA general, y ya está disponible al público.

En Argentina, GPT-3 participa regularmente de una competencia literaria. Ernesto Mislej (cofundador de 7Puentes, empresa de minería de datos y machine learning) envía poemas y cuentos escritos con GPT-3 al Mundial de Escritura, que se hace tres veces al año. Mislej, que también es profesor en la Universidad de San Andrés y en la Universidad de Buenos Aires, afirma que “las máquinas que hacen arte” son la razón por la cual estudió computación. Ubica el inicio de este movimiento en la corriente de “arte algorítmico” de principios de la década del sesenta, cuando un plotter controlado por una computadora imprimía obras. El papel del artista entonces consistía en programar las acciones que haría la impresora.

Hoy, Mislej toma las consignas del Mundial de Escritura y le escribe a GPT-3 solo una “semilla generadora”. “La consigna del año pasado consistía en ‘cosas que se hacen en la cama’. Me fui a una idea visual de un poema que había escrito hace un montón que decía ‘el hombre que dormía en una cama de libros’”, cuenta a crisis. “La puse en la generadora de textos, y me generó la figura del expediente judicial. El bicho se dio cuenta, vaya uno a saber cómo, que los expedientes judiciales ‘se duermen’”. El cuento resultante narra la historia de un padre que pide justicia por su hijo, con flashbacks que cimientan la relación entre ambos.

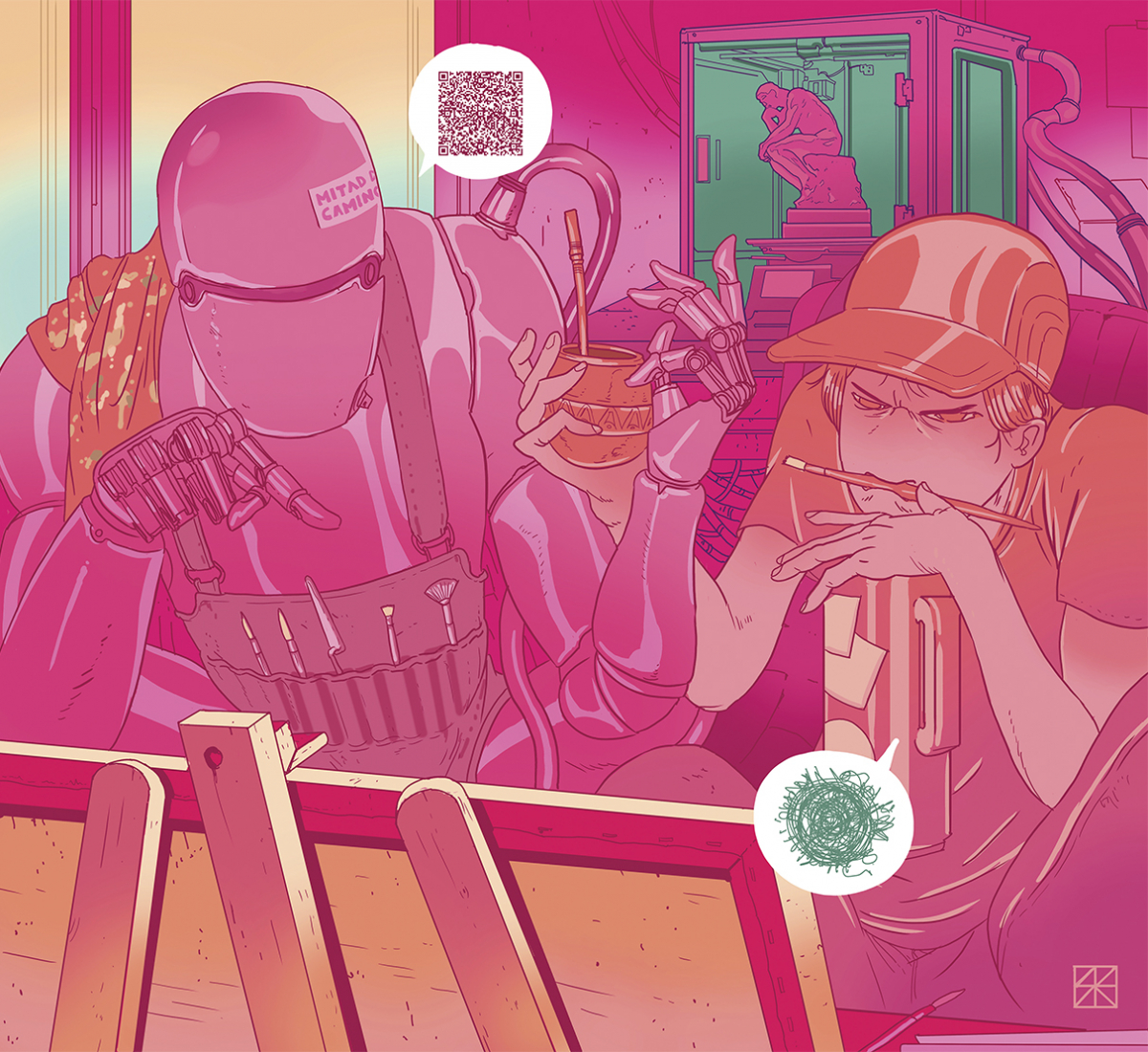

¿Cuál fue el trabajo de Mislej? “El bicho generó cien párrafos, y yo como artista seleccioné los que me servían para la idea, que fui terminando de construir en diálogo con el bicho. Yo, un humano, edité su cuento. Partí de una semilla flexible y subjetiva, que generaba una apertura muy grande, y yo tenía que estar ahí en sintonía, escuchando lo que decía la máquina y girar, volantear y ser abierto como para darle cabida a lo que me proponía”. Mislej, que llama a estos bots “bichos” o “pibes”, dice a crisis que está “fascinado” por la “creatividad” de la herramienta: “Soy una especie de padre que pega el dibujo de sus pibes en la heladera. Como sé lo complejo y sofisticado que es construir esas piezas, mi recorrido está completamente guiado por el asombro”.

No es el único asombrado. Ni siquiera los desarrolladores de IA comprenden cómo funcionan y por qué dan los resultados que dan. Las capas y capas de redes neuronales hacen que sus procesos internos sean inescrutables: las IA no podrían explicar sus propias decisiones. Son, como la mente humana, cajas negras.

Pablo Weber es un cineasta cordobés cuyos tres cortometrajes bastaron para ponerlo en la mira de la crítica nacional. En los últimos dos años, sus películas fueron programadas y premiadas en festivales de Estados Unidos, China, España, Austria, Chile y Rusia. La autoría en sus películas es problemática: él no filma, usa archivos audiovisuales. En su primer largometraje –Ecos de Xinjiang– , una IA no solo será un personaje: Weber también está coescribiendo el guion con GPT-3. Relata a crisis: “No la uso para nada que sea dramático, ni para cuestiones que hagan avanzar la historia, esas son decisiones que tomo yo. Lo que hago es, en conjunción con la herramienta, formar imágenes poéticas o pequeños sintagmas, aberturas”. Para Weber, se trata de un encuentro en el que la IA ayuda al humano: “Halla pequeñas conjunciones, un adverbio, un adjetivo, un sustantivo; ‘acá me falta este color, acá me falta esta textura’, y por ahí la máquina te tira algo que no se me hubiera ocurrido sin ella”. Para escribir el teaser de la película, que se proyectó en el Festival Internacional de Cine de Mar del Plata pasado, el cineasta escribió en GPT-3 “el planeta es una máquina, una computadora gigante”. “La máquina me tiró ‘sus cálculos quiebran el espacio’. Y yo agregué ‘lo quiebran hasta que le duele’”.

Para él, el cruce entre arte e IA encierra un dilema político: “ningún artista quiere estar en contra de la tecnología. Te enfrentás ante una situación en la que sos un pelotudo tipo Elon Musk o un Pepe Mujica, y no podés adoptarlo críticamente, generar reflexiones, ni usar conscientemente la herramienta”.

Ya en 2020, Weber proyectaba que “los seres humanos vamos a vivir rodeados de texto, de imágenes, videos y voces generadas por IA. Va a haber que aprender a convivir con ello y nuestros sistemas institucionales y políticos se van a tener que adecuar”. Y citaba a Gilbert Simondon, filósofo de la técnica: “El ser humano puede llegar a ser un director de orquesta en una sinfonía de máquinas y cálculo. Pero también se puede ver inscripto como un elemento más dentro de una totalidad que no comprende, en un sistema que lo explota, lo humilla y empobrece sus sentidos y sus capacidades cognitivas”. Para el cineasta, estamos a las puertas de un evento “cuasi apocalíptico”.

una paleta de bits

En 2018, un algoritmo estampa su firma algebraica Min (G) max (D) Ex [log (D (x))] + Ez [log (1-D (G (z)))] en su propia obra. Semejante al arte pictórico europeo del siglo XVIII, la “pintura” fue nombrada El retrato de Edmond Belamy y vendida por 420.000 dólares en Nueva York. La IA que generó la obra fue alimentada por el colectivo Obvious, un grupo de artistas con base en París, con 15.000 retratos pintados entre el siglo XIV y el siglo XX. Un velo borroso cubre la totalidad de la obra, el rostro de la figura es apenas distinguible.

La novedad duró poco: hoy están disponibles al público herramientas de fácil manejo que trabajan con bases de datos infinitamente mayores, produciendo resultados mucho más sofisticados a nivel estético y conceptual. Tales son los casos de DALL-E, una herramienta creada por OpenAI basada en GPT-3; Stable Diffusion, de la empresa Stability.ai; o MidJourney, un proyecto independiente. La dinámica de funcionamiento para todas es la misma: el usuario le da un texto (prompt) y, a partir del pedido, ellas crean una imagen.

Esta compleja máquina puede imitar las corrientes estéticas y estilos de la historia del arte. Pero hoy la herramienta es usada por internautas que generan imágenes con prompts del estilo de “un carpincho cantando en el Teatro Colón” o “Darth Vader en la Quebrada del Humahuaca”. Pero también hay quienes ven en ella más que la última moda de la web. Gabriel Rud, diseñador de Imagen y Sonido, es un artista digital que exhibe y vende sus obras en NFT en galerías digitales como KnownOrigin y Artbag. La que considera su mejor pieza, una animación con estilo de los años ochenta llamada Episodes, tiene como temática la era medieval, el género fantástico y robots. Son imágenes fijas generadas con Midjourney y luego editadas para lograr “continuidad, repetición y diferencia”. Se vende por 0,2 eth (unos 245 dólares).

Rud dice a crisis que a veces se siente como un “farsante”. “Uno imagina algo y ese algo automáticamente es materializado. Y a veces, es superior a mis propias habilidades de representación”. Pero otras veces, se autopercibe como un “mago”. “Después de arduas pruebas y errores, uno se siente alguien que con la palabra produce cosas y siente cierto orgullo de haber encontrado un verbo, un adjetivo que de golpe parece ser el disparador de una magia”. El rol del artista con IA, entonces, es aprender a hablarle a la máquina. No es una tarea sencilla y ya generó otro mercado: la venta de prompts en webs como promptbase.com.

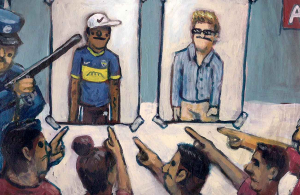

Pero, ¿quién es realmente el autor de las obras generadas con IA? Este año, Jason Allen logró engañar a los jueces del concurso de arte digital en la Feria Estatal de Colorado, en Estados Unidos. Tras la entrega de premios, Allen reveló haber creado la pintura con Midjourney, lo que encendió una polémica que persiste: hay quienes dicen que estas herramientas son solo una forma muy sofisticada de plagiar.

En opinión de Rud, “uno sabe que lo va a compartir como algo propio y que la calidad y el resultado es tan increíble que va a producir en los demás cierta admiración no merecida”. Y agrega que el nivel de control que los artistas mantenían sobre los procedimientos artísticos comenzó a diluirse.

Pablo Riera es doctor en física, programador, músico y parte del Laboratorio de IA Aplicada del Conicet. En la edición 2017 del Festival de Cine Científico del Mercosur, musicalizó documentales científicos de entre 1912 y 1914 con un sistema de IA de improvisación algorítmica basado en redes neuronales profundas. “Había un ensamble de músicos automáticos: una batería, un bajo, un sintetizador… Éramos cuatro músicos: tres artificiales y uno humano”, cuenta a crisis.

Como a Rud, a Riera también lo preocupa la autoría de las obras IA, pero en el otro extremo de la discusión: “Hay artistas que están en contra de las organizaciones como OpenAI, [porque] se están aprovechando de todo lo que hicieron otros artistas, sin acuerdo y de una forma muy abusiva. Empresas que tienen muchos recursos y guita se bajan absolutamente todas las imágenes artísticas de Internet, todas las fotos, entonces monopolizan”, afirma. Es decir, estos modelos utilizan, sin consentimiento, obras de artistas y aprenden a imitarlos. “El algoritmo nos está explotando”.

voces solo voces

El doblaje, es decir, el reemplazo de los diálogos de las películas o series por otros grabados en un idioma diferente, es un arte casi tan viejo como el cine sonoro. En Latinoamérica, se hace principalmente en México, pero también hay estudios de grabación en Argentina, Chile y Venezuela: zonas francas donde se habla ese idioma inventado para los productos audiovisuales del continente, el “español neutro”.

Pero la IA ya puede doblar películas prescindiendo totalmente de actores. Hay varias empresas que ofrecen el servicio. Algunas como la londinense Flawless, incluso, usan tecnología deep fake para modificar el movimiento de los labios de los actores y que coincidan con los parlamentos traducidos. Pero DeepDub, de Tel Aviv, es pionera. Fueron los primeros en usar la tecnología en un largometraje completo: Every Time I Die (ETID), thriller estadounidense de 2019. Si bien su adopción es incipiente por parte de la industria, su bajo costo comparativo (se prescinde de veinte actores en promedio para doblar un filme) hace sospechar que los actores de doblaje podrían convertirse pronto en una reliquia del pasado. En febrero de este año, DeepDub se aseguró 20 millones de dólares de inversores para hacer realidad este futuro.

Las ventajas de la tecnología, asegura a crisis Oz Krakowski, director de ingresos de DeepDub, van más allá del bajo costo y del menor tiempo requerido: “Podemos usar las voces de los actores originales. El modelo aprende los atributos de una voz y los aplica a un idioma diferente”, dice, y afirma que solo hacen falta entre dos y tres minutos de sonido para que la plataforma pueda replicar una voz. “Si tomo, por ejemplo, a Morgan Freeman, podés oír su voz saliendo del personaje hablando perfecto español, pero está generada por una máquina”.

DeepDub se presenta como una “casa de doblaje” que utiliza IA, machine learning y deep learning. Según Krakowski, luego de haber entrenado al modelo con horas y horas de audio de películas, pueden crear “voces sintéticas que no pueden ser distinguidas de una voz humana, sin importar sus emociones, ya sean hablar, gritar, llorar, hablar llorando… podemos afrontar todo ese rango con el sofisticado modelo que creamos”.

“No hay alma”, dice la actriz y directora de doblaje mexicana Gabriela Guzmán luego de analizar el tráiler de ETID doblado con IA. Y describe su proceso actoral: “Nunca sabemos qué nos va a tocar hacer. Te enterás en el mero momento: ‘Eres una mujer que acaba de perder a su hijo que está desesperada’ y tienes que llegar al punto donde está la actriz original”. Para Guzmán, una máquina jamás podría pasar por eso para lograr una interpretación. Pero quizás, justamente, una reflexión de la robot Ai-Da sirva para pensar que no es necesario: “No tengo experiencias subjetivas, pero puedo hablar de ellas”.

Guzmán se pregunta: “¿Cómo le dices a una máquina: `a ver, esta palabra dímela con una sonrisa´?”. Krakowski afirma que se puede. “El proceso está 80% automatizado”, dice. Del restante 20% se encarga el “humano en la película”: es decir, “la persona que revisa la calidad del resultado y puede hacer correcciones y ajustes en la interpretación”. Un director de actores sintéticos, gente de la industria del doblaje que se reconvirtió a trabajar en empresas como DeepDub. Eso no es todo: personas importantes del mundo del doblaje confirman a crisis que en Buenos Aires existen actores grabando en sesiones maratónicas para compañías asiáticas y europeas, entrenando a los algoritmos que probablemente los reemplacen.

Es que existe otra implicación en el reemplazo de actores de doblaje por IA: la laboral. Solo en México DF, hay alrededor de 800 actores registrados por la Asociación Nacional de Actores (ANDA). Existen, además, actores no afiliados al sindicato, sumados a miles repartidos por fuera de México. La ANDA está en alerta, pero saben que poco podrían hacer si, por ejemplo, Netflix decide implementar la tecnología. “Desde la Secretaría del Trabajo se podría hacer un comunicado”, dicen a crisis.

Krakowski lo ve como parte de un progreso irrefrenable. “Es obvio que, dentro de unos años, la mayoría de los proyectos se doblará así [con IA]”, dice. “En la historia de la humanidad, siempre estamos tratando de ser más eficientes y siempre hay una tecnología disruptiva que lo cambia todo. [Los actores de doblaje] tendrán que ajustarse”.

Pero las voces generadas con IA no solo amenazan con reemplazar a doblajistas afincados en Latinoamérica. La voz de Darth Vader, el icónico villano de la saga Star Wars (que comenzó George Lucas en 1977 y que no da indicios de finalizar, menos desde que la compró Disney), fue interpretada en todas sus apariciones en la pantalla grande por el renombrado actor estadounidense James Earl Jones. Pero Jones, de 91 años hoy, no puede llegar al tono grave y amenazante de Vader, y en 2022 aceptó ser sustituido por una IA generada por la compañía ucraniana Respeecher que, trabajando en sótanos bajo el asedio de misiles rusos, consiguió imitar cómo el actor sonaba hace 45 años.

“Obviamente en el doblaje al español, no se utiliza esa técnica: somos más artesanales y clásicos”, dice a crisis Sebastián Llapur, voz oficial de Vader en español latino. Desde este año, dejó de doblar al “maestro James Earl Jones”, como lo llama, y emula una voz generada por IA. Lo opuesto de la tecnología de DeepDub: Llapur oye y “calca” la performance de una máquina.

Cuando dobló a la IA en Obi-Wan Kenobi (2022), Llapur, que lleva 20 años en el negocio, no se dio cuenta de que era una voz artificial: Disney no le había avisado. “No lo sabíamos. Yo lo sospechaba, porque era muy difícil que sonara la voz del ‘maestro’ con esa claridad. Pero para mi trabajo, es lo mismo: tengo que tomar los tonos, escuchar y dar mi actuación. Darth Vader ya de por sí es robótico: el acting de James Earl Jones es duro en ese sentido. Nunca se altera, no grita. Es carente de emociones o está constantemente disimulándolas. Entonces, se presta al uso de esta tecnología sin que afecte mucho”, dice Llapur, jujeño y nacionalizado mexicano.

Para el actor, la movida de Disney tiene sentido: “Tienen claro que Star Wars va muy de la mano de la nostalgia. Y la nostalgia tiene que ver con la imagen y el sonido”. Quizás ese sea el mejor homenaje para James Earl Jones: entender que nadie puede reemplazarlo. Pero ahora, podemos clonarlo.

¿el gran reemplazo?

El arte con IA ya está empezando a tomar vuelo propio en obras donde el rol del humano es más el de un productor que el de un director de orquesta: en 2022, se publicó Fastwalkers, un cómic erótico con dibujos IA creados a partir de guiones IA, y ya existen cortos audiovisuales totalmente artificiales (la trama, escrita con GPT-3 o similares, es actuada por voces sintéticas y personajes 3D generados con IA). Estos productos mantienen el carácter onírico y ominoso de una “sensibilidad” brumosa no humana, ubicada en lo profundo del valle inquietante, que ya se adivinaba en el retrato de Edmond de Belamy de 2018.

¿Podría, entonces, una IA reemplazar a los artistas? Para Weber, “estas herramientas hacen miles y millones de correlaciones en tiempos inhumanos, ridículos, [pero] el arte no está hecho solo de correlaciones. Hay eventos: pequeñas o inmensas rupturas que van más allá de la correlación de datos”. Riera coincide en que, dado que los sistemas automáticos son entrenados en un entorno controlado, es difícil que logren producir nuevas olas de movimientos artísticos; “deberían ser mucho más conscientes de la época, entender lo que quieren los humanos”. Pero sabe que los algoritmos de recomendación de las plataformas de música, cine y series ya están empezando a recabar esos datos.

Ante la legislatura en Londres, Ai-Da responde: “La tecnología ya tuvo un enorme impacto en la forma en que creamos y consumimos arte. Por ejemplo, la cámara y el advenimiento de la fotografía”. “Es probable que esta tendencia continúe y no hay una respuesta clara a si la tecnología, para los artistas, es una amenaza o una oportunidad”, finaliza, con tono inmutable, antes de mover la cabeza, pestañear elaboradamente y perder toda expresión facial.